Licenza di uccidere

L’applicazione dell’intelligenza artificiale all’ambito militare è qualcosa che interessa molti Paesi (gli Stati Uniti negli ultimi anni hanno investito 18 miliardi di dollari in ricerca e sviluppo), anche se restano aperti molti interrogativi. Recentemente in Libia è stato impiegato per la prima volta un drone autonomo, cioè non controllato da nessun essere umano.

Quando pensiamo alle applicazioni dell’intelligenza artificiale ci vengono in mente vari ambiti della nostra quotidianità: dai veicoli a guida autonoma alla diagnostica medica, fino al riconoscimento facciale o agli assistenti vocali. C’è però un settore con cui molti di noi non si interfacciano tutti i giorni e nel quale gli algoritmi sono molto usati: quello militare.

Un recente report del Consiglio di sicurezza delle Nazioni unite, per esempio, sostiene che l’anno scorso, in Libia, siano state impiegate armi autonome, cioè non controllate dall’essere umano. Sebbene siano sperimentate da tempo all’interno dei laboratori, si tratterebbe del primo utilizzo sul campo. Non è chiaro se abbiano anche ucciso qualcuno (il report non affronta questa questione e il dispositivo in questione, un drone prodotto da una società turca, può operare sia in autonomia che con la guida di un essere umano).

Da alcuni anni siamo abituati ai droni militari guidati da remoto: soldati a migliaia di chilometri di distanza dal luogo del combattimento manovrano questi dispositivi come si trattasse di un videogioco. E decidono quando e a chi sparare.

Lo scenario descritto dal documento delle Nazioni unite potrebbe però creare un precedente: potrebbe infatti essere stato un algoritmo a scegliere di aprire il fuoco.

La ricerca e sviluppo di queste armi è riccamente finanziata: l’esercito statunitense ha messo a bilancio, tra il 2016 e il 2020, 18 miliardi di dollari.

Capacità reattiva

L’intelligenza artificiale sviluppata finora ha dei grandi punti di forza e degli altrettanto evidenti limiti rispetto all’essere umano. È in grado, per esempio, di analizzare grandi quantità di dati in poco tempo, ha capacità di calcolo molto potenti e può, se correttamente addestrata, leggere meglio alcune immagini mediche. Un oncologo vedrà un gran numero di tumori nella sua vita, ma questa casistica sarà solo una piccolissima percentuale di quelli che si possono dare in pasto a un algoritmo. Per questo, già oggi si sperimentano processi decisionali condivisi: la macchina può vedere qualcosa che sfugge all’occhio umano o, viceversa, confermare un’ipotesi del medico.

Oggi, però, l’intelligenza artificiale non è in grado per esempio di capire l’ironia. Inoltre, mentre a un bambino basta vedere un gatto per riconoscere la specie in altri esemplari che si troverà di fronte in futuro, alla macchina servono centinaia di migliaia di esempi. Gli algoritmi attuali, infine, sono privi di intuito, quella caratteristica umana che spesso ci fa trarre conclusioni avventate, ma a volte ci può salvare la vita. Una macchina prenderà sempre la decisione più razionale, che in alcuni contesti, come in uno scenario di guerra, potrebbe non essere quella giusta.

Non è infatti chiaro come i droni impiegati in Libia riescano a riconoscere i loro bersagli e, in generale, non si sa come una macchina possa reagire al caos di un campo di battaglia, dove intuire la mossa dell’avversario (umano, in questo caso) fa la differenza.

E cosa dire della responsabilità? Oggi non sappiamo a chi attribuirla nel caso un’auto a guida autonoma provochi un incidente. Chi risponderà quando un algoritmo ucciderà delle persone?

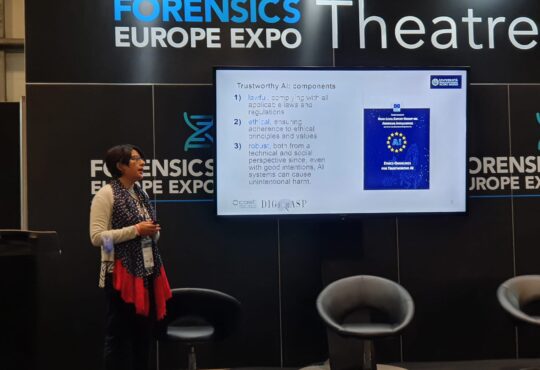

Le regole

Dal 2013 la Convenzione delle Nazioni unite sulle armi non convenzionali (Ccw) sta discutendo in merito alle armi autonome. La Ccw si occupa di regolamentare, tra le altre cose, le mine anti-uomo e i laser accecanti. In questi anni non si è raggiunto alcun accordo per l’opposizione di alcuni Paesi (Stati Uniti, Francia, Israele, Regno Unito e Russia), che hanno invocato la libertà nella ricerca sull’intelligenza artificiale.

Al momento oltre 180 organizzazioni non governative di tutto il mondo stanno portando avanti la campagna “Stop killer robots”, chiedendo di limitarne l’uso almeno in fase offensiva.

Secondo Stuart Russell, computer scientist a Berkeley e tra i massimi esperti nella ricerca sull’intelligenza artificiale, basterebbero i robot killer schierati da una sola persona per ucciderne molte migliaia.

Recentemente Stanley McChrystal, il potente generale che ha guidato per due anni le forze americane in Afghanistan, ha affermato che qualunque regolamentazione delle armi autonome è secondo lui destinata a fallire, nonostante questo significhi fidarsi ciecamente delle scelte compiute dalla macchina. L’essere umano, infatti, una volta che si è affidato all’algoritmo, non è più in grado di controllare ciò che succede né in tempo reale (accade tutto troppo velocemente affinché possa esistere una catena di comando standard), né dopo (al momento l’intelligenza artificiale è ancora una black box, una scatola nera nella quale è impossibile entrare per capire le motivazioni di una scelta).

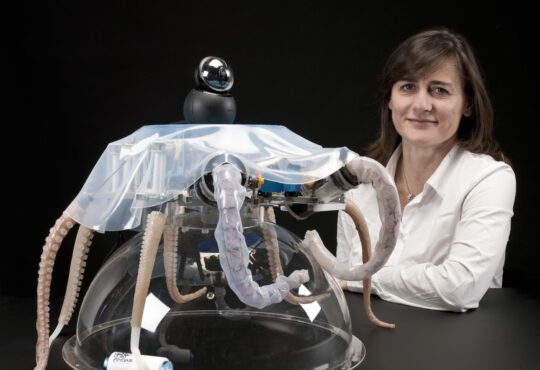

Leggi anche: Maggiordomo robot: si può fare?

Pubblicato con licenza Creative Commons Attribuzione-Non opere derivate 2.5 Italia.

Immagine: Pixabay