I miti e i fatti sull’intelligenza artificiale

Ovvero, come un gruppo di autorevoli scienziati propone modelli di sviluppo dell'AI che ne consentano un'evoluzione sicura per l'umanità. Partendo dallo sfatare alcune leggende

ATTUALITÀ – Siete terrorizzati all’idea che le macchine, un giorno non molto lontano, si ribelleranno contro l’umanità? O, al contrario, appartenete al novero di chi liquida i potenziali sviluppi futuri nell’ambito dell’intelligenza artificiale come poco più che ardita fantascienza?

Se avete risposto sì ad una delle due domande precedenti, potreste scoprire di essere in ogni caso lontani dalla realtà. A spiegarci il perchè ci pensano gli scienziati del Future of Life Institute, la cui missione dichiarata è catalizzare e supportare la ricerca e le iniziative per salvaguardare la vita e sviluppare visioni ottimistiche per il futuro. Individuando, a tal fine, i modi e le strategie più adeguate affinchè l’umanità possa decidere consapevolemente il proprio cammino, tenendo conto delle sfide e degli avanzamenti connessi con le nuove tecnologie.

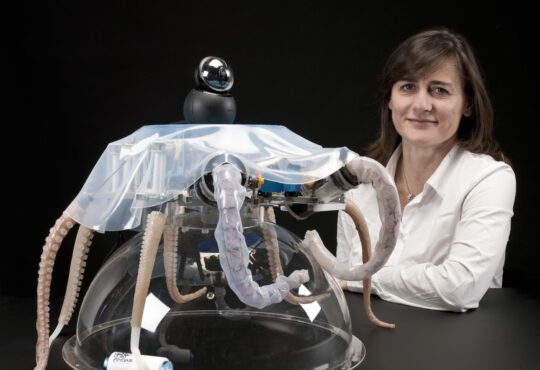

E si capisce subito che si tratta di gente che non scherza, dando un occhio alla composizione del comitato scientifico dell’avveniristica istituzione: vi si leggono, in successione, i nomi di eminenti rappresentanti del mondo delle corporate tecnologiche, come Elon Musk, ma anche del mondo del cinema, come Alan Alda e Morgan Freeman, passando niente meno che per Stephen Hawking, e includendo quella Francesca Rossi, docente dell’Università di Padova e attualmente chief scientist di IBM, e tra i principali promotori dell’altra grande alleanza nel settore dell’AI, The Partnership on Artificial Intelligence to Benefit People and Society, istituita tra i cinque colossi Facebook, Google, Amazon, Microsoft e, appunto, IBM.

Uno dei principali temi affrontati è, e non poteva non essere, il delicato rapporto tra lo sviluppo dell’intelligenza artificiale e la sicurezza degli essere umani. Tuttavia, l’approccio si caratterizza subito per una notevole pragmaticità, soprattutto nell’individuazione di alcuni falsi miti sull’argomento che sono, quasi inevitabilmente, entrati a far parte dell’immaginario collettivo negli ultimi anni, a cui gli scienziati dell’istituto contrappongono più realistici fatti. Passiamo allora in rassegna le interessanti contrapposizioni mito-fatto che ne derivano:

Mito 1: La superintelligenza, ossia la singolarità tecnologica, il punto della storia in cui la macchina supererà l’uomo, si manifesterà inevitabilmente entro il 2100. Oppure non si manifesterà mai.

Fatto 1: La superintelligenza potrebbe manifestarsi tra qualche decennio, qualche secolo, o mai. Gli esperti di AI hanno diverse opinioni in merito, ma ad oggi semplicemente non lo sappiamo.

Mito 2: Solo gli oppositori dell’utilizzo delle macchine temono l’intelligenza artificiale.

Fatto 2: Molti dei più eminenti ricercatori nell’ambito AI hanno espresso gravi preoccupazioni.

Mito 3: Una intelligenza artificiale potrebbe diventare cosciente o malefica.

Fatto 3: Un’intelligenza artificiale potrebbe diventare estremamente specializzata e perseguire obiettivi non allineati con quelli dell’umanità

Mito 4: I robot costituiscono la preoccupazione principale

Fatto 4: Un algoritmo disallineato rispetto alle esigenze umane costituisce la preoccupazione principale. Non ha bisogno di un corpo fisico, gli basta una connessione di rete.

Mito 5: L’AI non può controllare gli umani.

Fatto 5: L’intelligenza può rendere possibile una forma di controllo.

Mito 6: Le macchine non possono avere obiettivi.

Fatto 6: Un missile teleguidato, ad esempio, ha degli obiettivi.

Mito 7: La superintelligenza è assai lontana nel tempo.

Fatto 7: Ci vorranno decine di anni per arrivare alla superintelligenza, ma sono esattamente quelli che potrebbero occorrere all’umanità per capire come renderla sicura e non dannosa.

Secondo gli scienziati del Future of Life Institute, in sintesi, esistono due principali pericoli da considerare quando si parla di sviluppo di nuove tecnologie: il primo è quello di costruire macchine con uno scopo distruttivo, e perderne per qualche motivo il controllo.

Il secondo è molto più subdolo, perchè meno controllabile: costruire macchine che apparentemente non siano pericolose, o che addirittura siano progettate per scopi benefici, e che tuttavia sviluppino nel corso del loro ciclo di vita degli obiettivi che non collimano con quelli dell’umanità. Costruttivamente, allora, quali strade vengono proposte o indicate dagli scienziati per garantire che l’AI non diventi un nemico mortale dell’uomo?

Ce ne sono alcune che sembrano promettenti: ad esempio, il cosiddetto recursive self-improvement, ovvero insegnare all’intelligenza artificiale a migliorare sè stessa, basandosi sui propri errori. Oppure, uscire dalla calma e dall’isolamento asettico dei laboratori per abbracciare l’idea che una intelligenza artificiale eticamente evoluta debba essere sviluppata nel mondo reale. In modo da familiarizzare con gli umani, apprendendone caratteristiche, desideri, timori. E restando attaccati, in questo caso, alla speranza che non ne apprenda i peggiori e più distruttivi errori.

Leggi anche: Algoritmi per l’intelligenza artificiale: guida sintetica (non solo) per ingegneri

Pubblicato con licenza Creative Commons Attribuzione-Non opere derivate 2.5 Italia. ![]()