Neuroimmagini e machine learning per diagnosticare l’afasia

Ottenere una diagnosi di afasia è spesso difficile, proprio a causa dei problemi di comunicazione dei pazienti. Una nuova tecnica offre un approccio diverso e più mirato.

Il tratto che più caratterizza e distingue la nostra specie dalle altre è probabilmente l’uso del linguaggio verbale, della parola. Una capacità che appare relativamente scontata, ma che può subire deficit importanti a seguito di traumi, danni cerebrali o patologie neurodegenerative.

Uno degli aspetti più problematici legati all’afasia– come viene chiamata l’incapacità di comprendere o formulare correttamente il linguaggio, scritto e/o orale, a seguito di danni che riguardano regioni specifiche della corteccia cerebrale – è l’elevata difficoltà diagnostica. Spesso le difficoltà di linguaggio sono difficili da individuare, classificare e quantificare utilizzando i classici test: ciò è dovuto al fatto che solitamente i pazienti affetti da afasia non eseguono i compiti dei diversi test, vuoi perché non ne sono in grado, appunto per l’incapacità di comunicare, vuoi (fenomeno molto diffuso in un disturbo così impattante e invalidante come l’afasia) perché non intendono partecipare attivamente al test diagnostico.

Nel corso degli anni è stata quindi ribadita, all’interno della comunità medico-scientifica che si occupa dell’afasia, il bisogno di sviluppare un metodo diagnostico che sia il più possibile task-free, ossia che non implichi eccessivi sforzi da parte del paziente.

Machine learning e imaging cerebrale

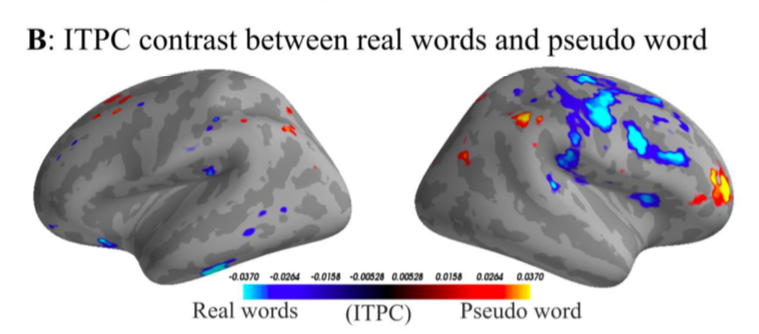

Bisogno a cui recentemente ha cercato di dare risposta un team di ricerca danese, che in uno studio pubblicato sulla rivista eNeuro illustra i risultati di un approccio multidisciplinare molto promettente: combinando tecniche di machine learning con analisi di imaging cerebrale il gruppo di ricerca è infatti riuscito a determinare se i partecipanti agli esperimenti stessero sentendo una parola reale o una “costruita” (che fosse verosimile nel suono, ma senza un reale significato), se la parola fosse legata a un’azione o astratta, o addirittura se la parola fosse grammaticalmente corretta o meno.

Tre livelli di discriminazione (lessicale, semantica e sintattica), il tutto basandosi solamente sui dati oggettivi provenienti dall’analisi della loro attività cerebrale, registrata tramite una tecnologia del tutto non-invasiva chiamata magnetoencefalografia (MEG). La MEG è una tecnica ad elevatissima risoluzione temporale – caratteristica che la rende ottimale per rilevare i repentini cambiamenti, nell’ordine di millisecondi, che avvengono in aree specifiche della corteccia cerebrale in risposta a un compito specifico – che sfrutta le proprietà elettromagnetiche dei neuroni: quando i neuroni in una determinata area sono attivi, comunicano tra di loro attraverso un segnale biochimico che viene trasferito attraverso la generazione di un potenziale elettrico.

La corrente elettrica così generata crea un piccolissimo campo magnetico intorno ad ogni neurone. Tanti neuroni che si attivano insieme in risposta a un compito generano quindi, in un’area della corteccia, variazioni del campo magnetico che possono essere captate dai sensori della MEG (Fig1).

Un nuovo paradigma sperimentale

I dati MEG sono stati registrati su dei volontari sani seguendo un paradigma sperimentale passivo: ai partecipanti infatti non veniva chiesto di ascoltare le parole proposte (cosa che sarebbe stata a tutti gli effetti un task cognitivo), bensì di guardare un video senza audio, mentre il flusso di parole scorreva in sottofondo, senza che essi ci prestassero attenzione. L’attività cerebrale nelle diverse frequenze è stata poi analizzata utilizzando un algoritmo di machine learning denominato Multivariate Pattern Analysis (MVPA), in grado di fornire una classificazione delle attivazioni neurali basati su un sub-set di dati, e non su ipotesi aprioristiche sulle localizzazioni spaziali o temporali del segnale di interesse.

L’elevata precisione con cui MVPA classifica le diverse attivazioni (in risposta ad esempio a parole grammaticalmente scorrette, o senza senso) promette ora importanti applicazioni nel campo diagnostico, in cui però sarà importante testare la robustezza dell’algoritmo a fronte di una situazione corticale per lo più sconosciuta. Tuttavia la natura stessa di questa metodologia, che non utilizza ipotesi a priori ma un piccolo sub-set di dati per “imparare” cosa sta facendo il cervello in un determinato momento, fa ben sperare. E sicuramente un nuovo tassello, nel complicato puzzle di comprensione-diagnosi-trattamento dell’afasia, è stato aggiunto grazie all’unione tra due discipline destinate ad andare sempre più a braccetto nei prossimi anni: neuroscienze e informatica.

Leggi anche: Analisi del sangue di routine? Non servono a niente

Articolo pubblicato con licenza Creative Commons Attribuzione-Non opere derivate 2.5 Italia. ![]() Fotografia Pixabay

Fotografia Pixabay