Il giornalista robot e altre storie

Gli algoritmi stanno diventando sempre più bravi a svolgere un compito ben preciso, ma restano ancora parecchio indietro rispetto agli umani su troppi fronti. Il filosofo del digitale Luciano Floridi spiega perché un giornalista batte il software di scrittura GPT-3

Alzi la mano chi, di fronte a un prato perfettamente tagliato, sarebbe in grado di capire se a compiere l’impresa sia stato un giardiniere (umano) o un robot tagliaerba.

Luciano Floridi, direttore del Digital Ethics Lab dell’Università di Oxford, mette subito le cose in chiaro: non ci riuscirebbe nessuno. “Non è più possibile, perché le macchine sono diventate molto brave a svolgere il loro lavoro, anche meglio degli esseri umani”.

Solo poche settimane fa un algoritmo ha realizzato il sogno di tanti giornalisti, riuscendo a pubblicare un articolo sul blasonato Guardian. Il pezzo sembra di qualità, o comunque paragonabile ad altri firmati da reporter in carne e ossa.

Siamo quindi a un passo dagli scenari fantascientifici, con la tecnologia che sta per diventare così intelligente da prendere il posto sugli esseri umani?

Il giornalista robot

GPT-3, il software che ha scritto l’ormai famoso pezzo del Guardian, si è premurato fin da subito di rassicurare l’umanità sul fatto di non avere nessuna intenzione di rimpiazzarla.

Eppure sembrerebbe creato proprio con questo scopo. Si tratta a tutti gli effetti di un sistema di intelligenza artificiale, che dopo un periodo di allenamento, durante il quale l’algoritmo vede molti esempi di testi scritti da umani, impara a crearne di propri. Gli informatici usano il termine “allenamento”, proprio per sottolineare come il meccanismo alla base dell’apprendimento della macchina non sia poi così diverso da quello dello sportivo che impara un nuovo gesto atletico. Questa fase è cruciale, perché un buon allenamento (fatto con tanti dati) determinerà l’efficacia del software e la sua somiglianza con i comportamenti umani.

Nel caso di GPT-3, la società che lo ha prodotto (OpenAI) non si è certo risparmiata: si parla di un investimento 12 milioni di dollari, per aver fatto allenare l’algoritmo su 175 miliardi di parametri (erano “solo” 75 miliardi nella precedente versione, l’ormai superata GPT-2).

La vendetta delle lavastoviglie

In uno studio appena pubblicato, Floridi e colleghi hanno testato l’algoritmo chiedendogli di completare testi letterari famosi. I ricercatori si sono sbizzarriti con diverse lingue e generi letterari, da Jane Austen a Dante. I risultati sono interessanti, impossibile negarlo: un computer è in grado di scrivere il finale di un racconto e persino una versione alternativa del sonetto di elogio a Beatrice della Vita Nova.

Ma c’è un ma: “Tutto questo non significa che GPT-3 sia intelligente, almeno non nel senso in cui siamo solito intenderlo”. Perché quando i ricercatori pongono al software una semplice domanda (“quanti piedi entrano in una scarpa?”), questo, invece di rispondere in modo puntuale come farebbe una qualunque persona, si inventa un improbabile dialogo a due (“non lo so” – disse il ragazzo, l’uomo rispose “Dieci” … e così via per diverse battute). In altre parole, svolge il compito per cui è stato programmato e l’unico che è in grado di fare, cioè scrivere testi. Senza necessariamente capire che cosa sta scrivendo.

Il punto si può riassumere così: “bravo” non è sinonimo di “intelligente”. “Siamo sulla strada del divorzio tra la capacità di portare a termine un compito e l’intelligenza – riflette Floridi. È la vendetta della lavastoviglie: brava ed efficiente nel lavare i piatti, eppure nessuno si sognerebbe mai di dire che è intelligente”.

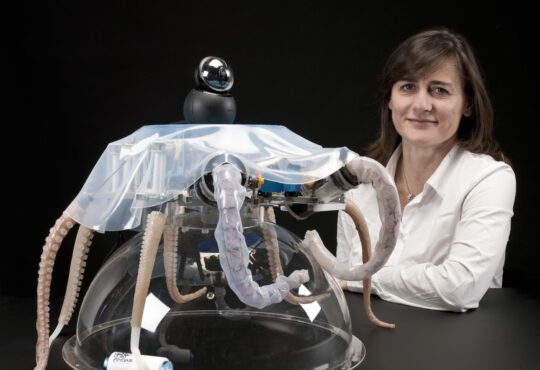

Le macchine oggi e domani

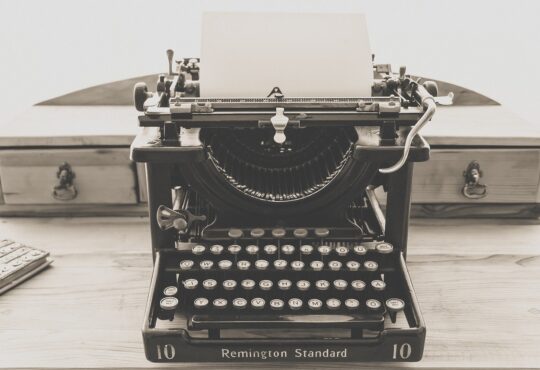

“GPT-3 è un gioiello di tecnologia, ma in quanto a intelligenza, coscienza e sensibilità non ha niente di più rispetto a una vecchia macchina da scrivere. L’intelligenza artificiale che siamo abituati a vedere nelle produzioni di Hollywood è destinata a non uscire dai film, un po’ come gli zombie e i vampiri”, conclude Floridi.

Tuttavia, il fatto che esista una tecnologia capace di svolgere compiti squisitamente umani fino a pochissimo tempo fa, qualche conseguenza la porta. Ce ne saranno di positive, come un aumento di servizi utili di chat automatiche o simili. Non mancheranno i lati oscuri: “Sarà sempre più facile produrre fake news e disinformazione”. E poi, semplicemente, ci saranno dei cambiamenti a cui adeguarsi: “Dovremo riscrivere le regole del Premio Pulitzer e abituarci all’idea di avere opere – letterarie ma anche musicali o di altro genere – prodotte da persone, altre da macchine e altre ancora in collaborazione”, riflette Floridi.

E, visto che chi scrive non nasconde una punta di preoccupazione, il filosofo rassicura: “Si va verso il valore aggiunto. I software possono sostituire il giornalista solo per i pezzi più semplici, ma l’articolo di qualità ha bisogno di intelligenza e comprensione. Doti che non sappiamo nemmeno come iniziare a implementare su un non-umano”.

Leggi anche: Siamo pronti ad accogliere le macchine in mezzo a noi?

Articolo pubblicato con licenza Creative Commons Attribuzione-Non opere derivate 2.5 Italia.

Immagine: Pixabay