JEKYLL – È iniziata la fase di valutazione, da parte dei GEV (Gruppi di Esperti della Valutazione) nominati dall’ANVUR, della qualità della ricerca sviluppata in istituti e università in Italia, nell’ambito del programma di Valutazione della Qualità della Ricerca, noto come VQR. A giugno 2013 l’ANVUR pubblicherà il rapporto finale: la valutazione delle strutture interverrà nella distribuzione del Fondo di Finanziamento Ordinario.

JEKYLL – È iniziata la fase di valutazione, da parte dei GEV (Gruppi di Esperti della Valutazione) nominati dall’ANVUR, della qualità della ricerca sviluppata in istituti e università in Italia, nell’ambito del programma di Valutazione della Qualità della Ricerca, noto come VQR. A giugno 2013 l’ANVUR pubblicherà il rapporto finale: la valutazione delle strutture interverrà nella distribuzione del Fondo di Finanziamento Ordinario.

Il VQR prende in considerazione diversi “prodotti” della ricerca, come articoli su riviste, libri, brevetti depositati, mostre ed esposizioni organizzate, prototipi e opere d’arte. Saranno valutate 95 università e 39 enti di ricerca. Partecipano alla valutazione professori ordinari o associati, ricercatori e assistenti universitari, ricercatori e tecnologi, a cui l’ANVUR ha chiesto di elencare in ordine di preferenza decrescente i propri “prodotti di ricerca” (3 per ricercatori/professori universitari, 6 per ricercatori appartenenti ad enti di ricerca). I GEV quindi valutano la qualità di tali prodotti, attribuendo un voto a ciascuno di essi. La somma dei voti concorre a definire la valutazione dell’ente/università.

I prodotti con più autori, però, potevano essere presentati una sola volta dalla strutture, pena esclusione del prodotto dalla valutazione. Era compito della struttura risolvere conflitti di questo tipo, selezionando tra gli articoli indicati da ciascun ricercatore quelli che evitassero sovrapposizioni, sempre però tenendo conto dell’ordine di preferenza espressa.

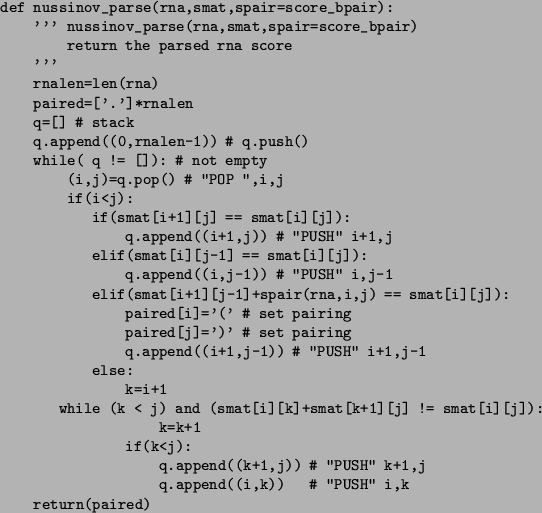

Risultato: per massimizzare il voto era meglio che non fossero i singoli ricercatori a scegliere i loro lavori migliori, ma che fossero gli enti/università a selezionarli. Vediamo un esempio estremo e semplificato, ma efficace: X è un ente con due soli ricercatori, A e B; A, un genio, è il primo autore di 6 articoli spettacolari (da 4 punti ciascuno), cofirmati però anche da B; A è anche autore di altri 6 articoli più scadenti (da 1 punto ciascuno) firmati da solo; B invece non si può dire che eccella: ha solo cofirmato i 6 articoli spettacolari scritti da A e nient’altro. In un caso del genere, sebbene A vorrebbe indicare i suoi 6 articoli migliori (6 x 4 = 24 punti), all’ente X conviene scegliere per A i sei più scadenti (6 x 1 = 6 punti), e assegnare a B i sei migliori. Così, infatti, la somma del punteggio sarà più alta (24 + 6 = 30 > 24), e l’ente X non risulta avere ricercatori pigri (e non riceve la penalità prevista nel caso in cui un ricercatore non abbia un numero sufficiente di prodotti).

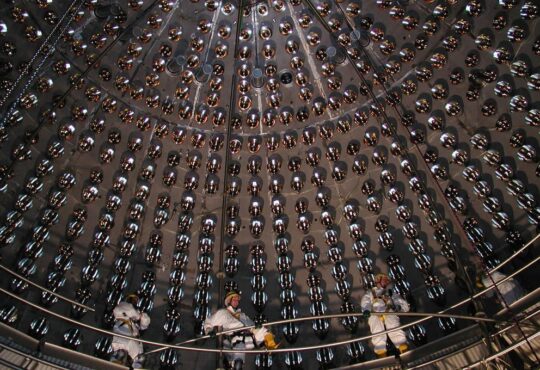

Per raggiungere questo risultato, alcuni enti e università italiani hanno elaborato un algoritmo di massimizzazione, indicando ai propri ricercatori quali pubblicazioni scegliere (o scegliendo direttamente al posto loro). Algoritmo tanto più necessario quanto più grande e complesso era l’ente, come per esempio nel caso dell’Istituto Nazionale di Fisica Nucleare (INFN), dove ci sono centinaia di ricercatori che hanno pubblicato centinaia di articoli. Lì i ricercatori sono stati esclusi dalla selezione delle pubblicazioni, e l’istituto ha dato la garanzia ai ricercatori che “né i dati delle selezioni, né tantomeno quelli relativi ai singoli, verranno mai usate (ancora ieri abbiamo avuto una rassicurazione pubblica del Ministero in persona)” (comunicazione interna del Presidente INFN ai Dipartimenti). Ce l’ha raccontato Alessandro Ferretti, ricercatore presso l’Università di Torino e l’INFN, come potete sentire in quest’intervista:

Un meccanismo simile è stato adottato, ad esempio, anche presso l’Università di Pavia, come ci ha spiegato il professor Giuseppe De Nicolao: “la selezione è stata guidata dall’obiettivo di ottenere la miglior valutazione possibile dell’ateneo e dei dipartimenti. Questo significa che, in alcuni casi, alcuni ricercatori hanno ‘ceduto’ i loro lavori più pregiati a coautori il cui contributo scientifico era stato minore”. Il tutto per “massimizzare il punteggio del dipartimento suddividendo opportunamente gli articoli tra i coautori”. “Queste negoziazioni sono state gestite manualmente a livello di singoli dipartimenti per via consensuale, essendo ben chiaro a tutti che non erano in gioco valutazioni individuali”, specifica De Nicolao.

Altrove invece, come ci ha riferito Michele Gristina, ricercatore presso l’Istituto per l’Ambiente Marino Costiero (IAMC-CNR) di Mazara del Vallo, la selezione è stata fatta effettivamente dai ricercatori, che si sono limitati a mettersi d’accordo per evitare sovrapposizioni in caso di articoli con più autori. Stesso discorso all’INGV.

Nascono allora due dubbi: la valutazione della qualità della ricerca non rischia d’essere influenzata dalla qualità dell’algoritmo eventualmente utilizzato? Un dubbio non da poco, visto che i voti verranno usati per l’allocazione dei fondi ad enti e università. Ma soprattutto: se venisse stabilito di utilizzare questi dati anche per valutare i singoli ricercatori, il “ricercatore A” come la prenderebbe?

Sebbene l’ANVUR abbia specificato che la valutazione non riguarderà “i singoli autori”, il dibattito è aperto e, in alcuni casi, causa di contenzioso all’interno degli stessi enti. Tutto è iniziato in seguito ad un esposto presentato da Pietro e Andrea Ichino alla Civit e al Garante dei Dati Personali, e a un loro articolo pubblicato sul Corriere della Sera il 14 giugno, in cui si chiedeva che venisse “reso noto in quale delle quattro classi di merito previste sarà posta ogni pubblicazione”, in nome della trasparenza. Andrea Ichino ha poi spiegato a Jekyll che “noi chiediamo che vengano messe on-line le valutazioni dei singoli prodotti con i nomi di tutti i loro autori. Poi ognuno farà le valutazioni che vuole. Ossia non chiediamo che l’ANVUR stessa produca un risultato medio per individuo, ma solo che renda accessibili i dati elementari”.

Richiesta che però non piace ai ricercatori, che a questo punto temono di essere valutati per articoli che, se avessero potuto scegliere, non avrebbero mai indicato.