RICERCA – Google Flu Trend: uno strumento per la raccolta e l’analisi dei dati sui casi di influenza in giro per il mondo, un’opportunità per comprendere meglio le malattie e prevederne la diffusione. Ma anche un modo come un altro per mostrare che lo studio dei big data non è infallibile, anzi, potrebbe essere addirittura fuorviante. Soprattutto se si basa sulle ricerche nel web che oramai quasi tutti facciamo nel timore d’esserci ammalati.

RICERCA – Google Flu Trend: uno strumento per la raccolta e l’analisi dei dati sui casi di influenza in giro per il mondo, un’opportunità per comprendere meglio le malattie e prevederne la diffusione. Ma anche un modo come un altro per mostrare che lo studio dei big data non è infallibile, anzi, potrebbe essere addirittura fuorviante. Soprattutto se si basa sulle ricerche nel web che oramai quasi tutti facciamo nel timore d’esserci ammalati.

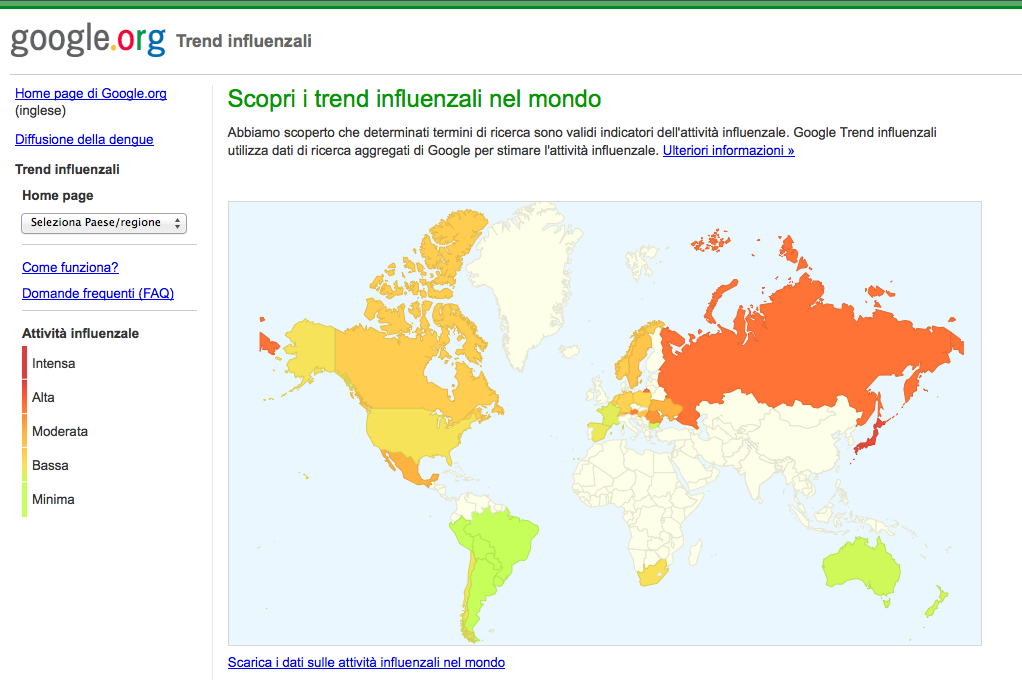

GFT ha sovrastimato i casi di influenza tra 2012 e 2013, ma anche quelli del biennio precedente, di più del 50%, ed è stata la rivista Science a pubblicare la ricerca “La parabola di Google Flu: le trappole nell’analisi dei big data”, finanziata dalla National Science Foundation. Lo scopo di Google Flu Trend (GFT) è quello di garantire un monitoraggio in tempo reale di tutti i casi di influenza che si verificano nel mondo, basandosi sulle ricerche che corrispondono a particolari termini associati con la malattia. Brividi, tosse, febbre, chi più ne ha più ne metta insomma, fino ad arrivare a intere frasi standard che, a quanto pare, googliamo molto in preda all’auto-diagnosi online.

Lo strumento d’analisi GFT non è rimasto inalterato negli anni, anzi, ha seguito le modifiche e i miglioramenti ai quali è andato incontro Google stesso. Eppure questo non è bastato a renderlo più attendibile, perché secondo Ryan Kennedy dell’Università di Houston e il suo team ha decisamente sovrastimato i casi di influenza verificatisi negli Stati Uniti durante gli ultimi anni. Come spiegano gli autori, alla base va messa in discussione la validità del raccogliere i dati da Twitter e Facebook, perché le aziende possono facilmente manipolare l’utilizzo di queste piattaforme di social-networking a favore dei propri prodotti e servizi.

Con queste premesse diventa dunque piuttosto dubbio quanto davvero i dati raccolti si avvicinino alla situazione reale. Ma il metodo non è completamente da buttare: secondo Kennedy e il suo team, combinando le informazioni raccolte da GFT con quelle fornite da metodologie più tradizionali si può raggiungere risultati molto accurati e affidabili. Non abbandonare il vecchio per il nuovo insomma, ma integrarli. “La nostra analisi ha dimostrato che la via più efficace da percorrere è quella di unire i dati provenienti da più fonti. Piuttosto che parlare di rivoluzione dei big data, dovremmo prima discutere di quella che riguarda tutti i dati, perché le nuove tecnologie che abbiamo a disposizione ora ci permettono di fare analisi accurate di ogni tipo”.

“Molte delle fonti dei cosiddetti big data sono compagnie private, che proprio come Google modificano costantemente i propri servizi in base al modello di business aziendale”, commenta Kennedy. “È necessario comprendere meglio come questo si rifletta sui dati che producono: altrimenti corriamo il rischio non solo di trarre conclusioni sbagliate, ma anche di prendere provvedimenti assolutamente non adatti”.