TEEP-SLA: migliorare l’autonomia delle persone con SLA grazie all’interazione uomo-macchina

I processi comunicativi delle persone con sclerosi laterale amiotrofica sono in genere assistiti da tecnologie che rilevano i movimenti oculari. Combinandole con l'elettroencefalogramma, all'IIT di Genova è nata una nuova tecnologia che migliora il sistema e lo rende più rapido

SENZA BARRIERE – Migliorare l’interazione uomo-macchina contribuendo a conferire maggiore autonomia alle persone colpite dalla sclerosi laterale amiotrofica (SLA) e impossibilitate a muoversi. È l’obiettivo di TEEP-SLA, alla lettera Tecnologie Empatiche ed Espressive per Persone con SLA, il pionieristico progetto nato all’Istituto Italiano di Tecnologia (IIT) e condotto in collaborazione con Fondazione Sanità e Ricerca e Fondazione Roma. L’obiettivo è creare un vero e proprio canale di comunicazione tra persona e macchina, tale da rendere i dispositivi sempre più vicini alle capacità e alle necessità degli utenti.

Tra i ricercatori del Biomedical Robotics Lab of Advanced Robotics Department dell’Istituto Italiano di Tecnologia coinvolti nel progetto vi è il neuroscienziato e postdoc Giacinto Barresi, impegnato in prima linea in TEEP-SLA fin dal suo avvio, nel 2015. A lui abbiamo chiesto i dettagli e gli obiettivi dell’interessante ricerca appartenente alla frontiera della bio-ingegneria. “Il progetto TEEP-SLA combina le conoscenze neuroscientifiche con la necessità di realizzare sistemi tecnologici che possano migliorare la qualità di vita di persone che presentano malattie degenerative come la SLA”, spiega Barresi, raccontando come questa patologia colpisce i motoneuroni portando a una perdita della capacità di movimento.

“In alcuni casi il paziente mantiene solo il controllo dei movimenti oculari, una condizione definita di locked-in. In altri la perdita di movimento è totale – total locked-in – e invalidante.” La persona è quindi privata delle capacità necessarie per svolgere semplici attività quotidiane, dal camminare al manipolare oggetti, scrivere, parlare, alimentarsi e badare alla propria sicurezza in modo autonomo. Da sempre la ricerca scientifico-tecnologica in questo settore mira a creare strumenti in grado di interpretare le informazioni che il corpo della persona può ancora comunicare, per tradurle in comandi verso dispositivi esterni. I processi comunicativi della persona con SLA sono solitamente assistiti da sistemi di rilevazione dei movimenti oculari, in modo da tradurre il movimento dello sguardo in un’azione predefinita: il paziente può controllare un cursore su uno schermo e fissare per qualche secondo l’oggetto dell’interfaccia utente (come la lettera di una tastiera), così da attivarla.

“Queste tecnologie già esistenti sono utili ma possiedono molti limiti”, specifica Barresi. Fruibili solo da pazienti SLA in condizione di locked-in, sono spesso incapaci di distinguere un movimento oculare finalizzato ad uno scopo – come scrivere – da un movimento puramente casuale, in grado di attivare in modo accidentale il sistema. “Il limite di queste tecnologie è rappresentato anche dalla difficoltà di utilizzo da parte del paziente. Pensate a quanta fatica comporti dover fissare attentamente per più secondi una lettera su uno schermo affinché il computer, tramite una telecamera, possa rilevare il segnale e tradurlo nell’indicazione desiderata”, specifica il ricercatore.

È qui che interviene il progetto TEEP-SLA integrando, attraverso il dispositivo EyeBCI, il sistema di riconoscimento dei movimenti oculari con un sistema di interpretazione della volontà del paziente basato sull’analisi dell’elettroencefalogramma. “Utilizzando le informazioni fornite dall’elettroencefalogramma abbiamo abbattuto i tempi di selezione oculare di una lettera sullo schermo, passando dai tre secondi necessari con il solo puntamento a 0,5 secondi con il sistema integrato EyeBCI. In altri termini, sebbene il puntamento della lettera continui a essere oculare, è come se il “click” avvenisse a livello mentale e il dispositivo elettronico è in grado di captarlo quasi nell’immediato”.

Ma non è tutto. Il sistema EyeBCI definisce l’aspetto espressivo della tecnologia utilizzata, tuttavia i ricercatori puntano a ottimizzare la comunicazione uomo-macchina anche a livello empatico, sfruttando tutte le informazioni prodotte in modo spontaneo dall’utente, relative al suo stato d’animo o al livello di stress al quale è sottoposto. Un ulteriore progresso su questo versante arriva dall’individuazione da parte degli scienziati di un sistema di controllo dell’errore commesso dal dispositivo, identificato attraverso l’analisi del potenziale di errore. “Il potenziale d’errore è un potenziale elettroencefalografico che si manifesta quando la persona vede deviate le sue aspettative nei confronti di un evento che ha tentato di controllare”. Un segnale molto utile poiché, riconosciuto dalla macchina, viene registrato come un comando interpretato in modo errato. “Pertanto, se l’indicazione fornita inizialmente alla macchina era quella di muoversi verso destra, a seguito dell’insoddisfazione dell’utente dalla quale scaturirà il potenziale d’azione, la stessa macchina riconoscerà l’errore e si muoverà nel verso opposto, rispondendo ora in modo corretto. Così, tutti i comandi successivi, corrispondenti a quel tipo di pattern di attivazione cerebrale, verranno interpretati in modo corretto”.

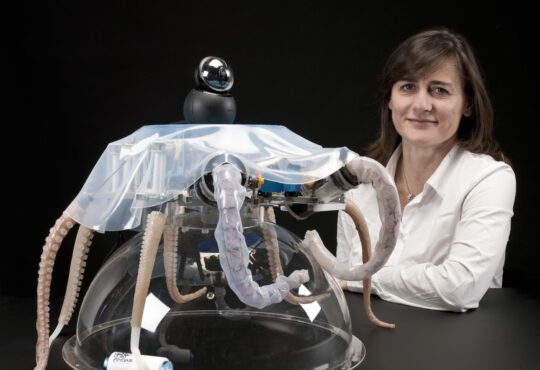

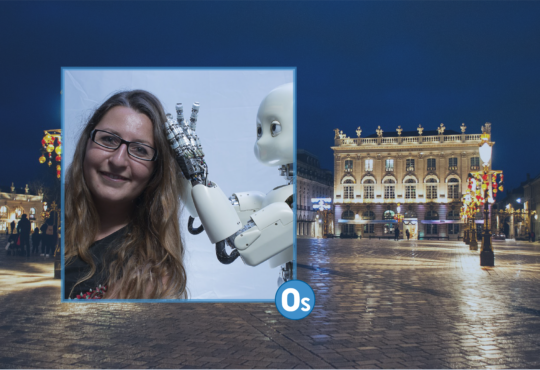

Una tecnologia molto utile se si pensa che i ricercatori di TEEP-SLA stanno lavorando per estendere il sistema al controllo di un robot di telepresenza che il paziente potrà manovrare tramite lo sguardo, per interagire con oggetti o persone presenti in un ambiente vicino o lontano. Un primo risultato in questa direzione è il sistema SoftBMI, capace di tradurre il movimento dello sguardo di un paziente nel controllo di un braccio robotico in grado di individuare e afferrare oggetti con forze variabili. Una serie di traguardi importanti quelli raggiunti dai ricercatori del progetto TEEP-SLA, e tuttavia ancora in fase di evoluzione: la ricerca, che ha giovato del fondamentale contributo di pazienti con SLA, si concluderà a novembre 2018.

Ascolta l’intervista a Giacinto Barresi, neuroscienziato dell’IIT

segui Milly Barba su Twitter

Leggi anche: Kimap: un’app e un progetto innovativo per mappare e scansare le barriere architettoniche

Pubblicato con licenza Creative Commons Attribuzione-Non opere derivate 2.5 Italia.