INTERVISTE – La nostra comprensione del cervello fa ogni giorno passi da gigante, raggiungendo traguardi che fino a pochi anni fa sembravano dominio esclusivo della fantascienza. I neuroscienziati stanno decodificando il linguaggio che i neuroni usano per comunicare tra loro – e permettervi di mettere insieme queste buffe linee nere che vi scorrono davanti agli occhi in una frase di senso compiuto. Mano a mano che questo linguaggio viene decifrato, i neuroscienziati lo usano per comunicare con il cervello bypassando i sensi: attaccando protesi elettroniche direttamente alla corteccia cerebrale. Dando la vista ai ciechi e facendo muovere gli arti a chi è rimasto paralizzato. Quanto manca ancora prima di creare The Matrix? OggiScienza ha chiesto un parere rassicurante ad Alberto Mazzoni, neuroscienziato dell’Istituto Italiano di Tecnologia di Genova, che si occupa di reti neurali e interfacce uomo-macchina.

INTERVISTE – La nostra comprensione del cervello fa ogni giorno passi da gigante, raggiungendo traguardi che fino a pochi anni fa sembravano dominio esclusivo della fantascienza. I neuroscienziati stanno decodificando il linguaggio che i neuroni usano per comunicare tra loro – e permettervi di mettere insieme queste buffe linee nere che vi scorrono davanti agli occhi in una frase di senso compiuto. Mano a mano che questo linguaggio viene decifrato, i neuroscienziati lo usano per comunicare con il cervello bypassando i sensi: attaccando protesi elettroniche direttamente alla corteccia cerebrale. Dando la vista ai ciechi e facendo muovere gli arti a chi è rimasto paralizzato. Quanto manca ancora prima di creare The Matrix? OggiScienza ha chiesto un parere rassicurante ad Alberto Mazzoni, neuroscienziato dell’Istituto Italiano di Tecnologia di Genova, che si occupa di reti neurali e interfacce uomo-macchina.

Tradizionalmente, la ricerca nelle neuroscienze si concentra sullo studio di come diverse parti del cervello reagiscono agli stimoli sensoriali. La gran parte degli esperimenti cerca di isolare e studiare le reazioni del cervello in risposta a stimoli semplificati, per esempio il moto barrette luminose su sfondo nero. Secondo te invece questo approccio è fuorviante e il vostro laboratorio studia le reazioni del cervello a situazioni di “vita reale.” Che differenze osservate?

Prima di tutto massimo rispetto per tutti i pionieri che hanno iniziato a decodificare il cervello con flash, scacchiere e puntini su uno schermo. Se Hubel e Wiesel cinquant’anni fa non avessero fatto vedere ai gatti barre luminose che si muovevano lentamente in verticale, orizzontale e diagonale, la nostra conoscenza del sistema visivo non avrebbe avuto fondamenta solide. Ma questa è solo un’approssimazione del comportamento del cervello. Adesso sappiamo che il cervello non è una tabula rasa, ma completa la sua percezione sensoriale con le aspettative che ha sulla realtà, in un gioco di feedback piuttosto complesso.

Gli oggetti che vediamo occupano una frazione rilevante del campo visivo e lo attraversano lentamente (guardate la vostra scrivania in questo momento). Se gli facciamo vedere delle sbarre che lampeggiano, le aspettative del cervello non saranno assolutamente utili – in questa prospettiva gli stimoli usati finora non sono una versione semplice di quelli naturali, ma una versione estrema e non obbligatoriamente rappresentativa. La principale differenza che vedo nei miei lavori quando uso stimoli naturalistici è la ricchezza della risposta.

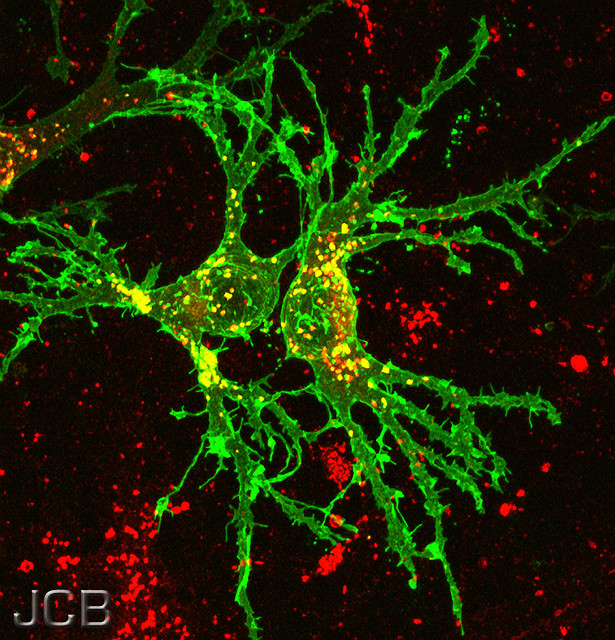

Il cervello non vuole sprecare energia – se lo stimolo è banale, userà il codice più semplice a portata di mano. Per codificare questa famosa barretta luminosa basta un numero minuscolo di neuroni, che saranno i soli a sparare impulsi elettrici (il linguaggio usato dai neuroni per parlare tra di loro), mentre gli altri non codificheranno un bel niente.

Mentre vado al lavoro in motorino invece i miei neuroni devono tenere accuratamente traccia di numerosi oggetti che si muovono a velocità alte e variabili, sennò io muoio. Non solo ogni neurone deve aumentare la risoluzione temporale del suo codice, ma nuovi tipi di codice al di là del livello di attività saranno necessari per coordinare lo scambio di messaggi tra vari neuroni, tenere memoria del passato e fare previsioni sul futuro, in pratica per collocare ogni singolo evento nel suo contesto spaziale e temporale. Nella mia esperienza, questi codici “avanzati” sono tipicamente dati da modi di oscillazione e sincronizzazioni fra neuroni su varie frequenze.

Un altro esempio è che la segregazione funzionale tra le varie aree del cervello (che si osservava ad esempio negli esperimenti con le barrette luminose) sta risultando una approssimazione piuttosto brutale negli studi con stimoli naturalistici: la corteccia visiva è influenzata dagli stimoli uditivi, tattili e viceversa. La faccenda, insomma si complica.

Tu stai proponendo un nuovo metodo sperimentale per studiare il cervello “in vivo.” Invece di applicare sulla corteccia cerebrale delle placche con centinaia di elettrodi, suggerisci che l’informazione che si può estrarre da un singolo elettrodo sia molto maggiore del previsto – come pensate di fare?

I neuroni trasmettono informazione principalmente tramite spikes – gli impulsi elettrici. Con un elettrodo si possono registrare spikes provenienti da un numero molto ristretto di neuroni, quindi la soluzione adottata di solito per avere una mappa completa di una zona del cervello è di aumentare il numero degli elettrodi in matrici sempre più fitte e larghe. Ma noi siamo ambiziosi, vogliamo costruire interfacce tra il cervello umano e la macchina. E agli esseri umani non piace avere fasci di cavi che escono dal cervello se si può evitare. Dobbiamo quindi tendenzialmente far sparire gli elettrodi.

L’attività neurale è come il maiale: non possiamo permetterci di buttare via niente. Negli ultimi anni si è iniziato ad analizzare le fluttuazioni del segnale sottostante gli spike nelle registrazioni. Ed è stata una piccola svolta. È come quando si è iniziato ad esplorare il cielo nelle bande di frequenza luminosa diversa dal visibile: zone del cielo che sembravano vuote sono diventate all’improvviso ribollenti di attività.

Queste piccole fluttuazioni nel cervello contengono infatti informazioni sulle modalità di comunicazione dei neuroni vicini, sull’input ai neuroni (là ove gli spikes sono l’output), sulle oscillazioni globali e altro ancora. Quello che stiamo facendo ora è decomporre questo segnale di sottofondo in componenti di frequenze diverse per vedere qual è il ruolo di ognuna di esse nei diversi contesti, un po’ come prendere un segnale radio e decomporlo nei vari canali. Questo consente di ottenere moltissima informazione, anche su dinamiche estese, da un singolo elettrodo.

Grazie a questo nuovo metodo sperimentale si è scoperto che il cervello funziona a vari livelli diversi, quello dei singoli circuiti neuronali controllati dalle scariche elettriche ma anche un altro livello, che potremmo definire “globale.”

Usiamo Internet come analogia. Immagina la rete dei cavi e delle linee wireless – questa è l’architettura strutturale di Internet. L’equivalente cerebrale sono assoni, dendriti e sinapsi che collegano i neuroni. Immagina adesso la rete degli scambi di informazione online – peer to peer, links sui siti, email, twitter, quel che ti pare – questa è l’architettura funzionale di internet. L’equivalente è dato dalle interazioni elettriche e chimiche tra i neuroni. Le due reti sono correlate (pensa all’intranet di una azienda) ma ovviamente non equivalenti. Secondo noi questa seconda struttura funzionale e dinamica nel cervello si basa su gruppi di neuroni che oscillano coerentemente con ritmi di frequenza che diminuisce all’aumentare della distanza. Mentre dormiamo il cervello oscilla lentamente e globalmente su basse frequenze, da svegli le singole aree oscillano localmente a frequenze molto più alte, mentre oscillazioni più lente trasmettono informazioni da un’area all’altra. L’analisi delle fluttuazioni di cui sopra secondo noi può contribuire a chiarire questa struttura di oscillazioni gerarchiche e le sue dinamiche.

Un aspetto della ricerca in neuroscienze è la creazione di modelli dei circuiti cerebrali, chiamati reti neurali. Una volta estratta e decodificata l’informazione dal cervello, possiamo usarla per creare delle interfacce uomo-macchina?

Le interfacce saranno sia sensoriali che motorie, come il braccio in questo video. Le neuroscienze computazionali alla fine servono proprio a creare i dizionari per tradurre in impulsi cerebrali il video registrato da una microcamera e consentire a un cieco di vedere. O per tradurre gli impulsi cerebrali nel movimento di un braccio robotico e consentire a una persona col collo spezzato di versarsi da bere. Io vengo dalla fisica teorica, ero abituato a pensare alla conoscenza come qualcosa di 1) etereo e 2) da perseguire per se. Adesso continuo a trovare la conoscenza bella, ma penso che la vera sfida sia nel renderla praticamente utile…

E ora la domanda delle cento pistole. I lettori si staranno chiedendo quanto manca ancora per creare finalmente The Matrix…

Durante il dottorato di ricerca studiavo le sanguisughe. Le sanguisughe sono segmentate come il lombrico e in ogni segmento hanno un numero molto limitato di neuroni (una dozzina) che segnalano se c’è una pressione applicata al segmento e inducono l’animale a scansarsi. È possibile fare il seguente esperimento: tocchi il segmento centrale della sanguisuga, e questa forma una C per allontanarsi dal punto di pressione. A quel punto apri la sanguisuga nel segmento centrale, trovi il neurone giusto, ci piazzi un elettrodo e dai una scossetta. La sanguisuga formerà la stessa identica C. Per lei è proprio come se tu l’avessi toccata col dito. Per gli invertebrati, insomma, volendo The Matrix è dietro l’angolo.

Per gli esseri umani la faccenda è incredibilmente più complessa. Ma nel caso di interazioni semplici come vedere la luce o spostare un oggetto, ci siamo già quasi, e nel giro di un decennio secondo me assisteremo a progressi sostanziali. Se poi si finisca in Matrix è da vedersi: le interfacce uomo-macchina possono essere usate come dicevamo sopra sia in lettura che in scrittura, e in entrambi i casi si possono ottenere grandi benefici o grandi danni. La questione, al solito, è politica e riguarda la ripartizione sociale dei benefici di una nuova tecnologia. Dipende dalla società far sì che la tecnologia sia open source, a basso costo e che vi sia un’alfabetizzazione scientifica tale da consentire il suo uso al numero maggiore possibile di persone e prevenirne gli abusi. Quindi probabilmente finiremo tutti in torri di incubatori molto presto… sempre che non vi siamo già.