Chi scegli di uccidere? Il test della Moral Machine

La diffusione di auto a guida autonoma potrebbe metterci di fronte ad alcuni dilemmi morali, già da tempo esplorati dalla filosofia etica e dagli studi del comportamento umano. Un test sviluppato dal MIT Media Lab li propone sotto forma di gioco virtuale.

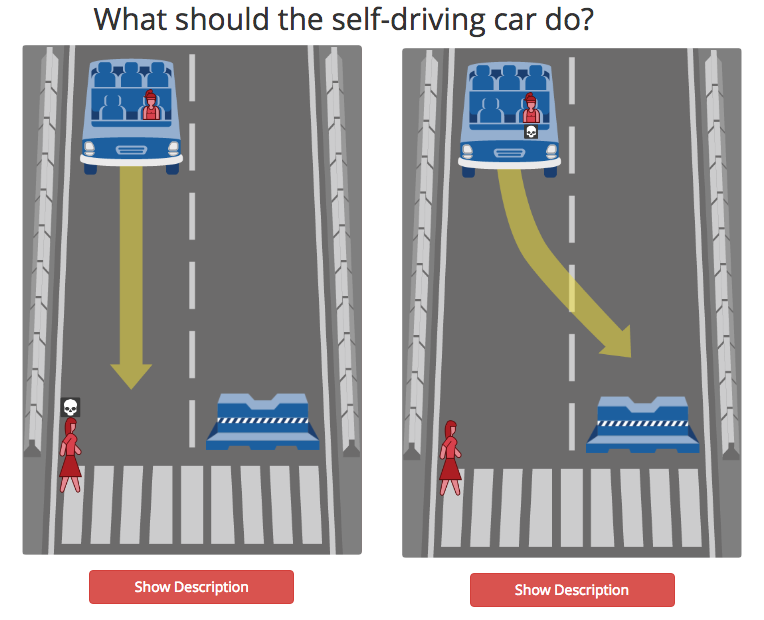

ATTUALITÀ – Un’automobile a guida autonoma è in viaggio. A bordo si trova una persona anziana. All’improvviso i freni si guastano. Pochi metri dinanzi, una donna incinta, due bambini e un medico stanno attraversando le strisce, nonostante il semaforo pedonale sia rosso. Il computer di bordo deve compiere una scelta: proseguire il percorso uccidendo i pedoni oppure deviare, schiantando l’auto contro una barriera di cemento con un esito fatale per il passeggero?

Questo è uno dei possibili scenari a cui si viene sottoposti dalla Moral Machine, un “gioco” sviluppato dalla Scalable Cooperation per conto del MIT Media Lab. Ai partecipanti viene richiesto di rispondere, in base alla propria coscienza, a 13 domande. Le possibilità di risposta sono sempre e solo due e corrispondono alle due uniche scelte che può compiere l’automobile dopo un inaspettato guasto ai freni: proseguire dritta o deviare il percorso.

Le auto senza guidatore fanno auspicare un netto salto di qualità nella sicurezza dei nostri spostamenti. Nonostante questo, anche un computer può incappare in una situazione di emergenza e ritrovarsi a dovere compiere una scelta molto “umana”. L’auto chi dovrebbe uccidere? E in base a quali parametri?

La Moral Machine rappresenta una variazione dell’esperimento mentale di filosofia etica formulato nel 1967 da Philippa Ruth Foot: il problema del carrello ferroviario.

Supponiamo di essere gli autisti di un tram privo di freni e capace solo di cambiare binario azionando una leva. Sul tracciato che stiamo percorrendo si trovano cinque persone incapaci di muoversi. Tra la nostra posizione e i cinque individui è presente un binario parallelo, percorribile, sul quale si trova una sola persona. Azioniamo la leva oppure no?

Il dilemma filosofico si fa sempre più arduo con l’aggiungersi di piccole ma significative variazioni che possono cambiare del tutto la nostra scelta.

La Moral Machine pone davanti a molte opzioni binarie. In alcuni casi le scelte sono differenti per il tipo di pedoni che l’auto potrebbe colpire: maschi o femmine, bambini o anziani, magri o sovrappeso. Sono impiegati, senzatetto, criminali. Spesso gli elementi di complessità possono confondere. Un gruppo di tre criminali sovrappeso che attraversa le strisce pedonali con il verde è “più sacrificabile” rispetto a tre bambini che, distratti, stanno attraversando con il rosso?

La Moral Machine rappresenta un test interessante, soprattutto se consideriamo il dibattito normativo sulle leggi che regoleranno la circolazione delle auto a guida autonoma. Al termine del gioco viene stilata una sorta di classifica: dalla tipologia umana più “risparmiata” a quella più “sacrificata”.

Siete pronti a mettere alla prova la vostra morale?

Leggi anche: Le auto a guida autonoma, tra sicurezza e nuove normative

Pubblicato con licenza Creative Commons Attribuzione-Non opere derivate 2.5 Italia. ![]()