Intelligenza artificiale, servono affidabilità e trasparenza

Sono questi gli obiettivi chiave da perseguire secondo l’Europa. A pochi giorni dalla proposta di legge europea sull’AI, cerchiamo di capire come siamo arrivati a questo punto e perché è importante regolamentare la materia.

Di recente, la Commissione Europea ha presentato ufficialmente la proposta di legge sull’intelligenza artificiale (AI). L’obiettivo del lavoro è duplice: scongiurare i rischi (anche etici) che questa tecnologia può portare con sé, ma – al tempo stesso – favorire tutti quegli sviluppi che possono avere ricadute positive per i cittadini.

Breve storia dell’AI

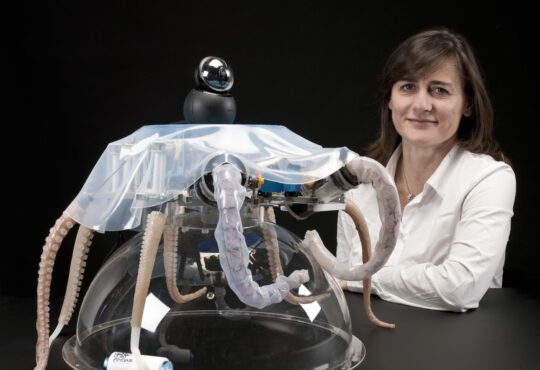

Sgombriamo il campo da possibili equivoci: l’intelligenza artificiale è molto diversa da quella umana. Sotto al cappello di “intelligenza artificiale” troviamo in realtà più tipi di tecnologie, che negli anni hanno incontrato più o meno fortuna a seconda del periodo storico. Quelle più in voga oggi si basano sul principio del machine learning, che prevede che una macchina impari a portare a termine un compito in autonomia, dopo aver visto una serie di esempi.

Tra le frontiere della ricerca in ambito di intelligenza artificiale ci sono le reti neurali che imitano il cervello umano, che funziona tramite una serie di neuroni connessi tra loro. In sistemi di questo tipo l’intelligenza non risiede nei singoli neuroni, quanto nelle connessioni. Nelle macchine (ma anche nell’essere umano) queste connessioni si auto configurano e si rinforzano a seconda degli stimoli ricevuti.

Questo filone di studio non è affatto nuovo. Se ne parlava già negli anni ‘70, ma poi le ricerche si erano arenate, per mancanza di potenza di calcolo e memoria, e perché non c’erano abbastanza dati per l’addestramento.

Una sfida da raccogliere

Negli anni ‘10 del Duemila però tutto cambia. Le grandi piattaforme riescono a raccogliere una quantità immensa di dati (si parla di Big Data), e le schede grafiche hanno aumentato esponenzialmente la potenza dei computer rispetto ai vecchi processori. Il metodo delle reti neurali è quindi diventato deep learning: oggi si possono far vedere alla macchina milioni di esempi e creare così reti di connessioni molto profonde. Secondo gli esperti, stiamo vivendo una “nuova primavera” dell’intelligenza artificiale.

Tutto questo, però, si porta dietro alcuni dilemmi di natura etica. Nel machine learning un programmatore non ha accesso al processo che la macchina fa per trovare le soluzioni, ma può influenzarla solo attraverso i dati di allenamento. Se questi sono sbagliati, può capitare che l’algoritmo impari anche cose come il razzismo o il maschilismo.

Inoltre, se c’è di mezzo il deep learning, spesso il ragionamento che fa la macchina diventa talmente complesso e articolato su così tanti livelli da sfuggire anche allo sviluppatore stesso. Succede, insomma, che a un certo punto non si capisca più il perché dietro alle decisioni dell’algoritmo. Questo può far paura, specialmente considerando che si fa sempre più uso dell’AI nel quotidiano. Da qui, la necessità di regolamenti ad hoc.

Tra sorveglianza e capitalismo

L’Europa, con questa proposta, traccia una nuova strada, che si distingue dagli altri Paesi. Al momento, nel mondo, si possono individuare almeno altri due modelli – molto diversi – di intendere l’intelligenza artificiale: Cina e Stati Uniti

Uno studio da poco pubblicato spiega che la Cina sta spingendo in avanti sull’intelligenza artificiale e sulla sua regolamentazione, ma anche che “uno sguardo più attento mette in luce le numerose scappatoie ed eccezioni che consentono al governo (e alle società implicitamente approvate dal governo) di aggirare la protezione della privacy e le questioni fondamentali riguardanti la mancanza di responsabilità e il potere decisionale illimitato del governo sulla sorveglianza di massa”.

Dall’altro lato, anche gli Stati Uniti, con il monopolio delle Big Tech, presentano un modello basato sul libero mercato non certo indenne da problemi.

La persona al centro

Il filosofo Luciano Floridi, ai microfoni di Radio Tre Scienza ha dichiarato una terza via c’è, ed è quella di “mettere la persona al centro”. Questo è il principio ispiratore della proposta, che per esempio non prevede l’utilizzo delle tecniche di riconoscimento facciale in spazi pubblici (con qualche eccezione, che però deve essere valutata e autorizzata caso per caso, come nella prevenzione del terrorismo). O ancora: è possibile registrare gli spostamenti delle persone per studiare meglio come evolve una pandemia, ma i dati devono rimanere anonimi.

Un aspetto interessante della proposta è che non impone solo divieti e sanzioni. Anzi, c’è la volontà di rafforzare l’adozione dell’IA e di aumentare gli investimenti in tutta l’unione, anche nella ricerca. Perché promuovere tutti gli usi “buoni” di questa tecnologia può portare vantaggi competitivi per le aziende del vecchio continente in praticamente tutti i settori economici. La presidente della Commissione europea, Ursula von der Leyen, ha dichiarato in un tweet che la proposta fa parte di un piano coordinato che serve a “garantire la nostra posizione di leader in AI a livello mondiale”.

Leggi anche: Intelligenza artificiale, in Italia manca la formazione dedicata

Articolo pubblicato con licenza Creative Commons Attribuzione-Non opere derivate 2.5 Italia.

Photo by Markus Winkler on Unsplash